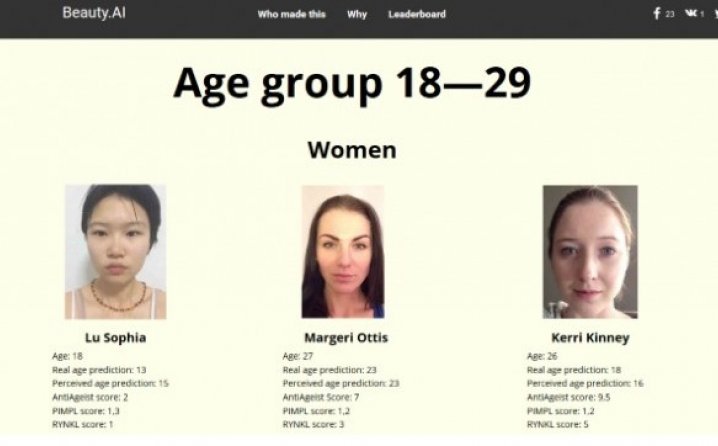

Prvo međunarodno takmičenje ljepote na kome su “mašine” bile sudije bilo je zamišljeno tako da se koriste objektivni kriterijumi kao što je simetrija lica i bore kako bi se pronašli najprivlačniji takmičari.

Nakon što je ove godine promovisano takmičenje After Beauty, oko 6.000 ljudi poslalo je svoje fotografije u nadi da će vještačka inteligencija uz korištenje komplikovanih algoritama odlučiti da je upravo njihovo lice najbliže “ljudskoj ljepoti”. Ali kada su se pojavili rezultati, kreatori su sa zebnjom zaključili da je jedan faktor povezivao pobjednike: robotima se nisu dopali ljudi s tamnom kožom.

Uvredljivi rezultati

Od 44 pobjednika gotovo svi su bili bjelci, nekoliko je bilo Azijata, i svega jedan taman. I to uprkos činjenici što su, iako je većina takmičara bila bijela, fotografije poslali i predstavnici drugih rasa, uključujući i velike grupe ljudi iz Indije i Afrike.

To je obnovilo rasprave o načinima na koje se algoritmima produžuju predrasude i dobijaju neželjeni, često uvredljivi rezultati.

Kada je Majkrosoft lansirao četbot Taj u martu, ubrzo je počeo da koristi rasistički jezik i promoviše neonacističke stavove na Twitteru.

A nakon što je prošlog mjeseca Facebook isključio ljude na mjestima urednika koji vode računa o novim pričama, algoritam je odmah počeo da promoviše lažne priče, uključujući i članak o čovjeku koji je masturbirao na sendvič s piletinom.

U svijetu, a naročito u SAD, zabilježen je ozbiljan porast rasizma. Naučnici sada kažu da ulogu u rasizmu, ksenofobiji i drugim oblicima diskriminacije ima i – matematika.

Iako je naizgled rasistički izbor ljepote podstakao šale i porugu, kompjuterski stručnjaci i zagovornici jednakosti u društvu tvrde da činjenica da AI (veštačka inteligencija) podstiče predrasude nije nešto s čime se treba šaliti. U nekim slučajevima može imati pogubne posljedice za ljude pojedinih rasa.

Beauty.AI – koji je napravila grupa Youth Laboratories i koji je podržao Majkrosoft – oslanja se na podatke s fotografija kako bi napravili algoritam za procjenjivanje lepote.

– Postoje brojni razlozi zbog kojih je algoritam davao prednost bijelim ljudima, a glavni problem je bio što podaci koji su korišzeni u projektu kako bi se ustanovili standardi privlačnosti nisu uključili dovoljno manjina – kaže Aleks Zavoronikov, jedan od vođa projekta Beauty.AI.

Iako algoritam nije napravljen tako da tretira svijetlu kožu kao znak ljepote, podaci koji su unijeti vodili su ka tome da robot donese takav zaključak

– Ukoliko nemate mnogo ljudi drugih rasa u bazi podataka, dobit ćete pristrasne rezultate. Kada napravite algoritam koji prepoznaje određenu matricu, možda nećete imati dovoljno podataka ili će podaci biti pristrasni – kaže Zavoronikov koji je i sam iznenađen pobjednicima u takmičenju.

Loši podaci

Najjednostavnije objašnjenje za pristrasan algoritam je da su ljudi koji su ih kreirali imali svoje duboko ukorjenjene predrasude. To znači da se, uprkos percepciji da je algoritam neutralan i objektivan, često mogu pojačati postojeće predrasude.

– The Beauty.AI rezultati nude savršenu ilustraciju problema. Ideja da možete napraviti kulturološki i rasno neutralan koncept ljepote je jednostavno nezamisliva – tvrdi Bernard Harkort, profesor prava na Kolumbija univerzitetu.

Ovaj slučaj je podsjetnik na to da su ljudi oni koji razmišljaju čak i kada za neke algoritme misle da su neutralni i naučno utemeljeni, navodi on.

Grupe za ljudska prava nedavno su iskazale zabrinutost da se softveri koji se koristi za predviđanje budućih zločinaca jednostavno oslanjaju na pogrešne statistike i rasno su pristrasni i štetni u policijskoj praksi.

– Loši podaci daju loše rezultate – kaže Malkia Siril, direktorica Centra za medijsku pravdu.

“Kompjuter izabrao one koje ja nikad ne bih”

Istraživanja ProPublica pokazala su da su softveri za predviđanje budućih kriminalaca imaju predrasude prema crncima, koji mogu dovesti do težih osuda.

– A to je jako bitno ako je ulog nečiji život – kaže Sorel Fridler, profesor kompjuterskih nauka na Haverford koledžu.

Glavni je problem, tvrdi, što su manjinske grupe po prirodi manje zastupljene u bazama podataka što znači da algoritam može doći do pogrešnog zaključka u vezi s tom populacijom, a da njegovi kreatori to ni ne uoče.

Postoje, navodi, proaktivni načini na koje algoritam može biti unaprijeđen kako bi se ispravile predrasude – poboljšanjem ulaznih podataka ili korišćenjem filtera kako bi se obezbjedilo da različite rase imaju jednak tretman.

Algoritmi su, smatra Siril, veoma ograničeni u načinama na koje mogu pomoći da se isprave društvene nejednakosti.

Zavoronikov najavljuje novo takmičenje u ljepoti ove jeseni i očekuje brojne promene algoritma koji bi uklonili diskriminatorske rezultate.

Ipak, dodaje on, teško da roboti baš mogu suditi o fizičkom izgledu.

– Mene više iznenađuje kako je izabrao najljepše. Od velikog broja odlučio se za one koja ja nikada ne bih izabrao – kaže Zavoronikov.